통계를 공부하다 보니 굉장히 불편한 것을 하나 만나게 됐다.

그것은 바로 표본에서 분산을 정의할 때 원래 알던 분산의 정의(편차의 제곱의 평균)가 아닌 다른 방식으로 정의한다는 것이다. 즉, 표본분산은 편차의 제곱을 표본의 크기로 나누는 것이 아니라, (표본이 크기-1)로 나누어 준다.

$$ s^2 = \frac{1}{n} \sum_{i=1}^{n}(X_{i}-\bar{X}) \quad (X)$$

$$ s^2 = \frac{1}{n-1} \sum_{i=1}^{n}(X_{i}-\bar{X}) \quad (O)$$

이렇게 정의하게 된 연유를 좀 찾아 보니, 자유도랑도 연관이 있는 것 같고, 여러 가지 설명들이 있더라. 그런데 자유도로 설명하는 것은 아직 내 수준에서는 도저히 이해가 안되고, 그나마 수긍이 되는 설명으로 정리해본다.

먼저 불편추정량(Unbiased Estimate)이라는 것에 대해서 알아야 한다. 모집단에서 표본을 뽑았을 때 우리는 표본평균이나 표본분산 등의 표본 통계량을 계산할 수 있다. 그런데 표본을 뽑아 통계량을 계산하는 행위 자체의 근본적인 목적이 바로 모집단의 모수를 추정하는 것이다. 이런 모수를 추정하기 위한 표본 통계량들을 추정량(Estimate)이라고 한다.

아마도 추정량에 대한 개념이 없이 나보고 표본평균이나 표본분산을 계산하라고 했으면 원래 일반적인 평균과 분산의 개념으로 계산을 했을 것이다. 평균은 (모든 원소들의 합/집단의 크기), (분산은 편차의 제곱의 합/집단의 크기) 이런 식으로. 그런데 앞에서 말했듯이 표본을 추출하는 것 자체가 모집단의 모수를 추정하는 것이므로, 통계학에서는 표본 통계량을 '추정량으로써' 간주하여 다르게 정의하는 듯하다. 즉, 추정량의 역할을 해야하므로 기존의 알던 정의와는 다르게 정의될 수 있다는 것을 받아들여야 마음이 편해진다.

목적 자체가 모집단의 모수를 추정하는 것이므로, 추정량은 모집단의 모수를 잘 추정할 수 있도록 정의되는 것이 좋다. 좋은 추정량의 조건이 4가지는 아래와 같다.

1) 불편성 (Unbiasedness)

2) 효율성 (Efficiency)

3) 일치성 (Consistency)

4) 충분성 (Sufficiency)

여기서 표본분산을 계산할 때 $n$이 아니라 $n-1$로 나누어주는 이유와 관련이 있는 것은 1) 불편성이다. 불편성이란, 편향이 없다(Unbiased)라는 뜻이다. 그렇다면 편향이 있다 or 없다 라는 것은 무엇을 의미하는 걸까? 이런 상황을 생각해보자. 모집단의 모수를 파악하기 위해 표본을 뽑아 표본 통계량을 추정량으로 이용하려고 한다. 이 때 표본평균을 이용한다고 해보자. 표본평균은 중심극한정리에 의해 모평균을 평균으로 하는 정규분포를 따른다. 그렇기 때문에 표본을 여러번 뽑아도 표본평균들은 모평균보다 크게만 나오거나 작게만 나오지 않고 크거나 작게 균등하게 나올 것이다. 즉 표본평균은 그 자체로 편향되지 않는 불편성을 지니고 있다. 따라서 우리가 일반적으로 생각하는 평균의 정의가 아래처럼 그대로 적용될 수 있다.

$$ \bar{X} = \frac{1}{n}\sum_{i=1}^n X_{i} $$

즉, 이것을 통해 불편성이라는 것을 수학적으로 정의하자면, 표본의 추정량의 기댓값이 모수와 같아야 한다고 말할 수 있다(표본평균이 그런 것처럼). 따라서 표본평균은 불편추정량으로써 다음을 만족하는 것이다($\mu$는 모평균).

$$ E(\bar{X}) = \mu $$

하지만 표본분산은 어떨까? 표본분산도 표본평균처럼 모분산을 기준으로 크거나 작거나 균등하게 나올까? 즉 불편추정량의 조건인 다음을 만족할까?

$$ E(s^2) = \sigma^2 $$

이것을 확인해보기 위해, 우리가 원래 알고 있던 분산의 정의, '편차제곱의 합의 평균'으로 한 번 확인해보자. 모평균은 $\mu$, 모분산은 $\sigma^2$라고 할 때,

$$\begin{matrix} E(s^2) &=& E(\frac{1}{n}\sum_{i=1}^n (X_{i} - \bar{X})^2) \\ &=& \frac{1}{n}E(\sum_{i=1}^n (X_{i}^2 - 2X_{i}\bar{X} + \bar{X}^2) \\ &=& \frac{1}{n} E(\sum_{i=1}^n X_{i}^2 - 2\bar{X}\sum_{i=1}^n X_{i} + \sum_{i=1}^n \bar{X}^2) \\ &=& \frac{1}{n} E(\sum_{i=1}^n X_{i}^2 - 2n\bar{X}^2 + n\bar{X}^2 ) \\ &=& \frac{1}{n} \sum_{i=1}^n E(X_{i}^2) - E(\bar{X}^2) \\ &=& \frac{1}{n} \sum_{i=1}^n (\mu^2 + \sigma^2) - (\mu^2 + \frac{\sigma^2}{n}) \\ &=& \frac{n-1}{n}\sigma^2 \end{matrix}$$

계산해보니 $E(s^2) = \sigma^2$를 만족하지 않는다. 즉, 표본분산은 불편성을 만족하는 불편 추정량이 아니다! 다시 말해 표본분산은 '좋은 추정량'이 아니다. 따라서 우리는 표본분산이 좋은 추정량이 되게 하기 위해 정의를 약간 수정해주어야 한다. 그것은 바로 분모 $n$을 $n-1$로 바꾸어주는 것이다. 바꾸고 위 계산과정을 따르면 정확하게 $\sigma^2$이 나온다. 이것이 바로 표본분산을 구할 때 $n$이 아닌 $n-1$로 나누어주는 이유가 되겠다.

나는 사실 이것이 상당히 불편한데, 표본분산을 정의할 때 우리가 일반적으로 알고 있는 분산의 정의와 충돌하기 때문이다. 뭔가 표본분산을 '좋은 추정량'으로 만들어주기 위해서 억지로 다시 정의해준 느낌?.... 아무튼 그렇다고 한다.

'Study > 통계' 카테고리의 다른 글

| t-분포 (Student's t-distribution) (0) | 2020.03.24 |

|---|---|

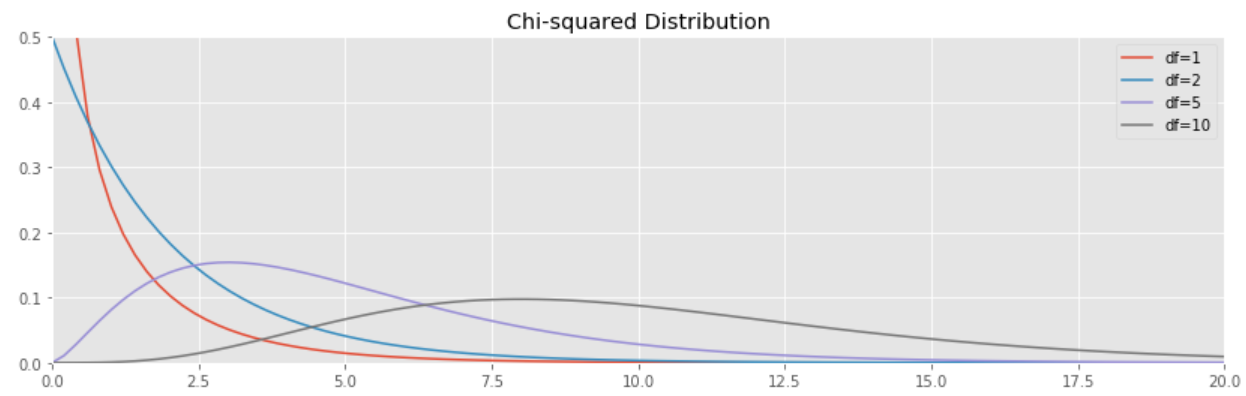

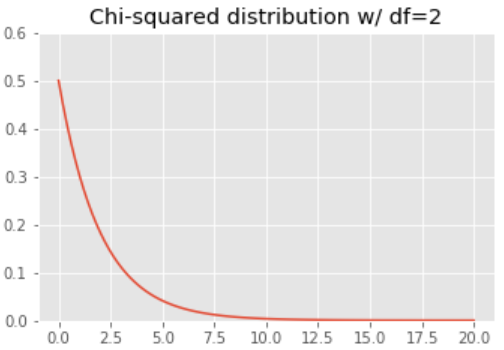

| 카이제곱분포(Chi-squared distribution) (0) | 2020.03.19 |

| 통계적 추론 - 가설검정(Hypothesis test) - 2 (0) | 2020.03.12 |

| 통계적 추론 - 가설검정(Hypothesis Test) - 1 (0) | 2020.03.10 |

| 통계적 추론 - 통계적 추정(Statistical Estimation) (0) | 2020.03.05 |